مقابله اپل با سو استفاده جنسی از کودکان ؛ اسکن تصاویر کاربران برای پورنوگرافی کودکان

اپل به تازگی از اقدامات امنیتی خود برای کودکان در iOS و iPadOS رونمایی کرده است. از جمله اقدامات اپل عبارتند از اسکن کردن تصاویر، محو کردن تصاویر در آیمسیج، تشخیص مطالب مربوط به سو استفاده جنسی از کودکان در آیکلاد و اطلاعات به روز شده برای سیری و جستجو.

به گفته اپل این ویژگیها در زمان عرضه فقط در ایالات متحده آمریکا در دسترس خواهند بود. با این حال انتظار میرود در آینده نزدیک، در مناطق بیشتری گسترش یابد. اپل میگوید که حفاظت از کودکان یک مسئولیت مهم است.

همچنین بخوانید:

- تمام مدلهای آیفون ۱۴ از صفحه نمایش ۱۲۰ هرتزی ProMotion بهره میبرند

- اگر میتوانستم خجالت میکشیدم، تبعیض جنسیتی حاصل از سیری!

- یک مادر و پسر بیش از هزار آیفون تقلبی به اپل قالب کردند!

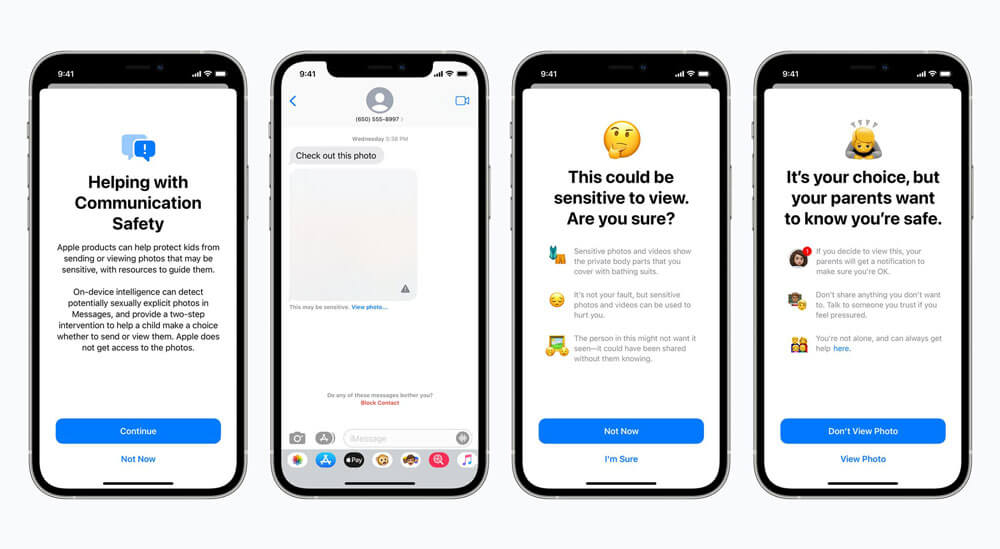

ویژگیهای برنامه مسیج

اپل میگوید وقتی یک کودک عضو iCloud Family است و یک تصویر جنسی را دریافت یا ارسال میکند، یک پیام هشدار دریافت خواهد کرد که این یک تصویر حساس است. اگر کودک انتخاب کرد که با این حال تصویر نمایش داده شود، پنجره دیگری ظاهر میگردد که توضیح میدهد چرا این عکس حساس است.

در این لحظه والدین تعریف شده در iCloud Family، یک اعلان دریافت میکنند و همچنین لینکی برای راهنماییهای بیشتر برای آنها ارسال میگردد.

به گفته اپل این ویژگی با استفاده از یادگیری ماشینی کار میکند و تجزیه و تحلیل اینکه یک تصویر جنسی است یا خیر در خود دستگاه صورت میگیرد. اپل تاکید کرده که آیمسیج دارای رمز گذاری سرتاسری است و اپل به هیچ پیام و یا عکسی دسترسی ندارد.

اسکن تصاویر برای سو استفاده جنسی از کودکان

به گفته اپل آیکلاد قادر به تشخیص تصاویر سو استفاده جنسی از کودکان است. اپل میگوید که در صورتی که این قبیل تصاویر در آیکلاد ذخیره شوند، میتواند آنها را به مرکز ملی کودکان گم و استثمار شده گزارش دهد. این مرکز یک سازمان غیر انتفاعی است که با مجریهای قانون در ایالات متحده آمریکا کار میکند.

اپل میگوید که تمامی این پروسه روی دستگاه کاربر انجام میشود و در صورت مشاهده تخلف، ممکن است که گزارش گردد.

قبل از اینکه تصویر روی آیکلاد آپلود شود، با هشهای غیرقابل خواندن تصاویر سو استفاده جنسی از کودکان مطابق داده میشود. اگر تطابقی پیدا شود، چیزی ایجاد میشود که اپل آن را «ووچر ایمنی رمزنگاری» مینامد. اگر سیستم از آستانه تعریف شده گذر کند، بازبینی در سیستم صورت میگیرد.

اپل معتقد است که سیستم آنها بسیار دقیق است و مزایای قابل توجهی را در زمینه حریم خصوصی نسبت به سایر تکنیکهای موجود دارد. این سیستم یک روش موثر برای شناسایی سو استفاده جنسی از کودکان، و در عین حال محافظت از حریم خصوصی کاربران است.

به عنوان بخشی از فرآیند، کاربر نمیتواند از آن چیزی که برای یافتن تصاویر سو استفاده جنسی از کودکان برای تطبیق استفاده میشود، متوجه گردد. این کار برای جلوگیری از سو استفادههای احتمالی است.

سیری و جستجو

اپل همچنین برای محافظت از کودکان تغییراتی را در جستجو و سیری داده است. اکنون سیری میتواند به کاربران برای گزارش سو استفاده جنسی از کودکان کمک نماید. این دستیار صوتی دسترسی به منابع مربوطه و آموزش تهیه گزارش را فراهم میکند. اگر کاربران هر چیزی را که مربوط به سو استفاده جنسی از کودکان است را جستجو نمایند، سیستم عامل مداخله میکند. به گفته اپل، سیستم عامل به کاربر توضیح میدهد که علاقه به این موضوعات مضر و مشکل آفرین است و منابعی را نیز برای این مسئله ارائه میدهد.